Вышла новая версия SiteAnalyzer, в которой добавлены возможности указания произвольных HTTP-заголовков и использования виртуального robots.txt.

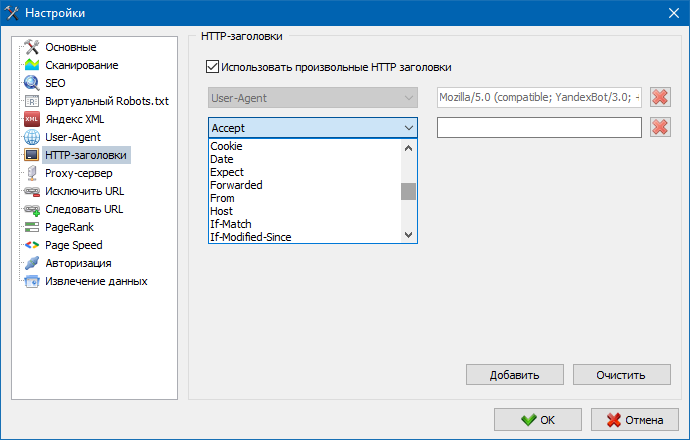

Указание произвольных HTTP-заголовков позволит анализировать реакцию сайта и страниц на разные запросы.

Например, кому-то может понадобиться отдавать в запросе Referer, владельцам мультиязычных сайтов захочется передавать Accept-Language|Charset|Encoding, а у кого-то есть потребность в передаче необычных данных в заголовках Accept-Encoding, Cache-Control, Pragma и т.п.

Использование виртуального robots.txt вместо реального, размещенного на сайте, пригодится при тестировании сайта, когда, например, нужно просканировать определенные разделы сайта, закрытые от индексации (либо наоборот – не учитывать их при сканировании), при этом не нужно физически вносить изменения в реальный robots.txt и тратить на это время разработчика.

Виртуальный Robots.txt хранится в настройках программы и является общим для всех проектов.

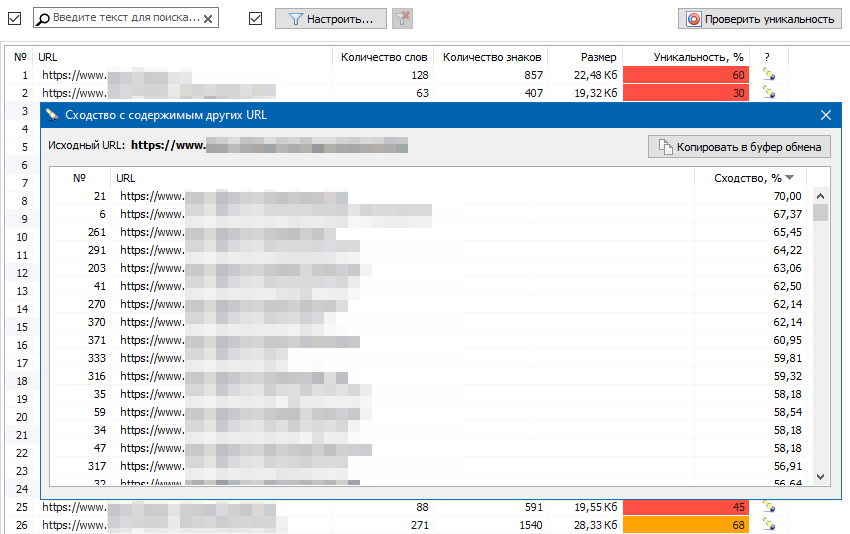

Также на вкладке проверки уникальности контента добавлено окно отображения списка страниц, наиболее близких по уникальности к выбранному URL:

Еще в новой версии SiteAnalyzer 2.6:

- добавлена возможность отмены процедуры тестирования работоспособности списка прокси в любой момент во время теста

- пересканирование произвольных URL проекта теперь происходит в несколько потоков, исходя из настроек программы

- в раздел настроек Яндекс XML добавлен сервис SERPRiver для проверки индексации страниц в Яндексе

- восстановлена работа функции Custom Search, предназначенной для поиска контента на сайте

- в списке проектов добавлено отображение даты последнего сканирования проекта

- добавлена возможность перетаскивания по папкам нескольких проектов мышью, а также используя контекстное меню

- добавлены дополнительные кнопки для проверки Google PageSpeed и уникальности контента на соответствующих вкладках

- добавлена возможность открытия в браузере файла robots.txt для интересующего сайта

- добавлена возможность открытия выбранного URL на сайте web.Archive.org

- добавлена колонка «Источник» на вкладке «Изображения»

- оптимизирован учет правил исключенных URL при сканировании сайтов

- добавлено использование регулярных выражений RegEx

- ускорено удаление URL в проектах

Напомним, в предыдущей версии SiteAnalyzer, представленной в июле, были реализованы проверка уникальности контента, скрейпинг данных (извлечение данных с сайта) и проверка скорости загрузки страниц по Google PageSpeed.